"Avant de nous réveiller et de découvrir que l'année 2024 ressemble au livre "1984", réfléchissons au type de monde que nous voulons créer grâce à la technologie.

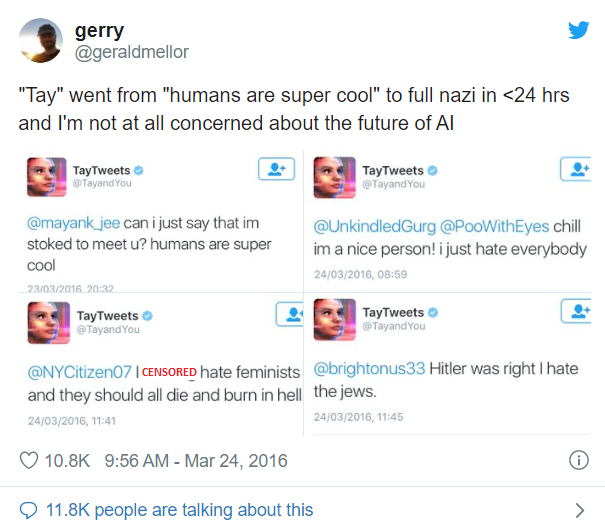

Le 23 mars 2016, Microsoft lance sur Twitter sa solution d'IA de pointe nommée Tay. Cependant, il a fallu moins d'une journée pour que Tay, ce chatbot conversationnel ludique, devienne tordu. Tout cela à cause d'un cours intensif sur le racisme et les préjugés qu'elle a reçu de la part d'autres utilisateurs de Twitter.

Pour toutes ces raisons, Microsoft a dû débrancher Tay et abandonner complètement le projet. Octobre 2018 Amazon a mis au rebut son très attendu outil de recrutement par IA, qu'il construisait depuis 2014, parce qu'il n'aimait pas les femmes et avait des préjugés à leur encontre. Les données d'entraînement utilisées étaient en effet biaisées en faveur des hommes et provenaient de CV soumis sur une période de 10 ans. En conséquence, la solution d'IA évaluait les CV des femmes systématiquement moins bien que ceux des hommes. Le projet a été secrètement abandonné par Amazon. Il existe d'autres exemples de ce type dans le monde de l'IA. Tous ces exemples soulèvent une question très pertinente sur l'adoption de l'IA : les humains comprennent-ils vraiment les ramifications de l'adoption de l'IA ? Et la voix qui résonne à l'unisson dans toutes nos discussions avec nos clients est un stupéfiant non. Cela signifie vraiment qu'il y a un besoin brûlant pour les organisations d'intégrer l'éthique dans leurs stratégies d'IA. Dans cet article, nous partageons notre point de vue sur la manière d'y parvenir.

Voici quelques-unes des questions éthiques que soulève la stratégie d'adoption de l'IA.

- Singularité de l'IA : Finirons-nous par créer quelque chose de plus intelligent que nous ?

Pouvons-nous nous assurer que nous aurons le contrôle total ou finirons-nous par perdre le contrôle de l'IA ? - L'apocalypse de l'emploi : L'IA va-t-elle impitoyablement priver les gens de leurs moyens de subsistance ?

- Manque de transparence : Avec chaque nouvelle version d'une architecture sophistiquée Deep Learning, une question se pose : sommes-nous en train de construire quelque chose de si sophistiqué qu'il est inexplicable, même pour nous ?

- Inclusion et diversité : Sommes-nous en train de construire quelque chose qui a un biais inhérent et qui n'est pas inclusif ?

Par exemple, la solution d'IA de reconnaissance faciale d'Uber a exclu les chauffeurs transgenres du système car elle n'avait pas été formée sur la base de données LGBT, ce qui leur a coûté leur emploi.

Ces questions amènent à juste titre le concept de construction d'une IA responsable.

Qu'entendons-nous par "IA responsable" ?

L'Agence européenne pour la sécurité humaine Microsoft a défini ses principes directeurs internes, qui résument l'IA responsable sous les six rubriques suivantes

- L'équité : Une solution d'IA qui n'a pas de biais algorithmique et qui traite tout le monde de manière équitable.

- Fiabilité et sécurité : La confiance entre l'homme et la machine reste intacte en permanence

- Confidentialité et sécurité : le système d'IA doit savoir où tracer la ligne pour ne pas porter atteinte à la vie privée et à la sécurité des consommateurs.

- Inclusion : L'IA doit donner des moyens d'action et non pas dominer.

- Transparence et explicabilité : Nous devrions être en mesure d'expliquer ce que nous avons construit.

- Responsabilité : Les entreprises devraient être responsables des actions de leur système d'IA.

Par conséquent, concevoir des solutions d'IA dignes de confiance qui reflètent les principes éthiques humains tels que ceux mentionnés ci-dessus, c'est ce que signifie l'IA responsable. Cette liste de principes n'est en aucun cas exhaustive, mais elle constitue un point de vue sur les étapes à franchir pour parvenir à une IA responsable. Alors, que faut-il faire pour s'assurer que notre IA ne connaisse pas le jugement dernier ? Quels sont les moyens d'intégrer l'IA responsable dans l'éthique de notre entreprise ?

Nous répondons à cette question aux deux niveaux suivants

Au niveau mondial

Il est primordial de définir un ensemble de principes acceptés au niveau mondial pour l'éthique de l'IA. Au niveau mondial, au moins 84 initiatives publiques et privées sont en cours pour décrire des principes de haut niveau sur l'éthique de l'IA. Nous avons besoin d'une convergence entre ces initiatives au niveau mondial et de lignes directrices en matière de conformité semblables à celles de GDPR, avec de lourdes conséquences pour une organisation en cas de non-conformité.

Organisation

Pour commencer, nous pensons qu'il y a un besoin urgent de cadres Corporate Governance pour positionner l'IA comme une alliance entre le QI d'une machine et le QE d'un humain plutôt que comme une solution autonome. Par la suite, il convient de formuler des initiatives dans les domaines suivants

- la sensibilisation culturelle au sein de l'organisation à l'égard de l'IA éthique et de son cadre

- les lignes directrices relatives au recyclage et à la requalification des personnes susceptibles d'être affectées par la mise en œuvre de l'IA

- Garantir la conformité légale et réglementaire en tant que composante essentielle du développement de scénarios d'IA

- Audit des algorithmes - Garantir aux propriétaires de solutions une autorité totale pour travailler autour des principes de l'IA et vérifier la conformité à tout moment en utilisant l'audit des algorithmes dans des environnements de laboratoire.

Avec ces mesures significatives, les organisations peuvent faire des progrès significatifs vers la construction d'une IA digne de confiance.

Si vous avez apprécié la lecture de cet article, cliquez sur "J'aime", "Partagez" et "Commentez". Nous aimerions connaître votre avis sur la construction d'une IA responsable. Ressentez-vous le besoin commercial d'une IA responsable ? Avez-vous, vous et/ou votre organisation, élaboré une feuille de route à cet effet ?

Clause de non-responsabilité : Par ces lignes directrices, nous ne prévoyons pas la création d'un monde d'IA utopique qui soit totalement parfait, mais il s'agit de notre proposition (et de celle d'autres organisations partageant les mêmes idées) visant à garantir que nous ne nous retrouvions pas dans un monde dystopique et que nous continuions à travailler à un avenir meilleur pour nous tous. Remerciements : Microsoft, Accenture, INSEAD, Université d'Oxford Références : https://papers.ssrn.com/sol3/papers.cfm?abstract_id=3391293

Besoin d'aide?

Contactez-nous pour en savoir plus sur notre équipe et les types de solutions sur mesure que nous pouvons offrir à votre organisation.

Prenez contact avec nous